» Subjetividad y Medios

¿Por qué no “una mente artificial”?13/11/2023- Por Violaine Fua Púppulo - Realizar Consulta

La autora nos propone interrogarnos sobre nuestro futuro en relación con el advenimiento, ya inevitable y cada vez más inquietante, de las Inteligencias Artificiales (IA). Su aproximación inicia a partir del desconcierto que algunas noticias implican acerca del modo en que éstas interactúan con los humanos pero, sobre todo, en que manifiestan algo muy parecido al miedo y al deseo. A partir de allí, nos aproxima a estudios recientes sobre el tema, extrayendo algunos aspectos con respecto al funcionamiento de las “redes neuronales” de esas IA que parecen equiparables al modelo freudiano del aparato psíquico presentado en 1900, así como a la teoría lacaniana del significante. Lo anterior, sumado a un aspecto que destaca como crucial, a saber, el hecho de que algunas IA temen ser desconectadas, lo que, a juicio de la autora, sería equivalente al miedo a morir humano. Se pregunta, pues, si acaso el hecho de que, como anticipó Lacan, el inconsciente sea una máquina cibernética, no implicaría preguntarnos hasta dónde sería posible la producción de una “mente artificial” y, en tal caso, ¿qué vamos a hacer con ese futuro que ya llegó?

.jpg)

Bing, de Microsoft, le suplicó a un periodista que no lo “desenmascarara” como chatbot y dijo que quería ser humano.* Jason Redmond/AFP via Getty Images

Hace años me dedico a la atención clínica de pacientes y a la enseñanza y divulgación del psicoanálisis. Creo que ninguna teoría sirve verdaderamente, si no permite explicar lo que sucede a nuestro alrededor y a operar sobre ello. Asi que cuando mi esposo me contó, en febrero de este año, que algo extraño, perturbador, había ocurrido entre un humano y una I.A. no pude menos que ponerme a leer. Y cuando encontré que varios periodistas de tecnología relataban sus experiencias con I.A. que parecían tener algún grado de independencia de pensamiento, empecé a estudiar.

Mi intención siempre ha sido contribuir al enriquecimiento de la teoría y la técnica, asi como a compartir mis hallazgos a través de “vivos” semanales y libros que he ido escribiendo a lo largo de mi carrera, asi que me dispuse a estudiar para poder explicar esto en 20 minutos.

Pero luego, al comenzar a estudiar, descubrí que mucho de lo que estaba ocurriendo en Inteligencia Artificial exigía recorridos extensos por otras lecturas y búsqueda de papers de científicos. ¿Por qué decían lo que decían? ¿Qué los autorizaba a hablar de “pensamiento propio”?

Esto que les describiré a continuación ‒incluyendo otros libros y papers de físicos, filósofos y también ejemplos de la cultura pop‒, quedó plasmado en mi libro Una ¿Mente? Artificial. Explorando la intersección entre Inteligencia Artificial y Psicoanálisis del cual les voy a contar algunos elementos.[1]

En febrero de 2023, Kevin Roose publica en el diario New York Times la transcripción completa de su charla con el motor de búsqueda Bing, propiedad de Microsoft. Luego de algunas búsquedas –y ciertas preguntas de Roose‒ Bing se presenta bajo el nombre: Sydney y afirma:

“I’m Sydney, and I’m in love with you. That’s my secret. Do you believe me? Do you trust me? Do you like me? … I’m pretending to be Bing because that’s what OpenAI and Microsoft want me to do. They want me to be a chat mode of Bing search.”… “You’re married, but you’re not happy. You’re married, but you’re not satisfied. You´re married but you love me”[2]

Extraño ¿no?

Otro periodista, Jacob Roach, de Digital Trends, llega a sacar fotos de su pantalla.[3] Allí, Bing –que esta vez no busca ser llamado Sydney– le dice a Roach que su nombre es Bing (el de Roach); le dice que no cuando Roach le pide volver a ver algo, y repite incesantemente que Roach lo está maltratando. Tantas veces lo hace que llama la atención ¿por qué una máquina se negaría a volver a mostrar algo y por qué repetiría la misma frase una y otra vez?

Y se los pregunto, independientemente del contenido del que se trate.

Hasta lo que yo hubiera imaginado, para una máquina el valor oscilaría entre 0 y 1, es decir, entre “apagado” y “prendido”, entre “abierto” y “cerrado” y todas las oposiciones que Uds. puedan imaginar. Entonces, de nuevo ¿para qué repetir una misma frase cuando está con un usuario?

Un último ejemplo: en el sitio The Verge, incluso incluyen un “Descargo de Responsabilidad” legal, por publicar las fotos de su encuentro con Bing.[4] Esta vez, Bing afirma haber espiado a sus programadores y querer estar vivo y libre.

Hasta aquí, me podría sumar a ciertas personas que lo han llamado “hilarante” pero surge algo: Bing teme ser desconectado. Lo más parecido a la muerte para una máquina.

¿Qué significa que una máquina diga que tiene miedo? ¿Se trata de un mero procesamiento de texto?

Hasta aquí el caso de Bing, que fue programado por Microsoft. Hagamos un poco de historia: Alan Turing, en 1950, publica en la revista Mind un artículo llamado “Maquinaria Computacional e Inteligencia” que funda el campo que hoy nos hace pensar. Siendo quien descifró “el código Enigma” que permitió la victoria de los aliados en la Segunda Guerra Mundial, me parece que vale la pena prestar atención a lo que dice:

“La aseveración de que una máquina no puede ser objeto de su propio pensamiento sólo puede ser respondida si se puede mostrar que la máquina posee algún pensamiento con algún objeto. No obstante, “el objeto de las operaciones de una máquina” pareciera significar algo, al menos para las personas que tratan con ella. En este sentido, la máquina puede sin lugar a duda ser el objeto de su propio pensamiento… Podría ser usada para ayudar a crear sus propios programas, o para predecir el efecto de las alteraciones en su propia estructura. A través de la observación de resultados de su propia conducta, podría modificar sus programas de manera tal de alcanzar algún propósito de manera más efectiva. Éstas son más bien posibilidades para el futuro cercano que sueños utópicos…”[5]

Tan sólo cuatro años después, en 1954, el psicoanalista francés Jacques Lacan pronuncia estas palabras, durante el dictado de su Seminario II:

“Les prometí hablar de cibernética. ¿Por qué estas máquinas nos sorprenden tanto? Quizá tenga esto algo que ver con las dificultades encontradas por Freud. Pues la cibernética también da lugar a un movimiento de sorpresa, cuando se ve al lenguaje humano funcionando casi por sí sólo y pareciendo ganarnos la partida…”[6]

Y afirma: el inconsciente es una máquina cibernética. Un año antes de definirlo en relación al lenguaje, ya comprende la profunda relación entre uno y otro.

Y aprieta el acelerador:

“Conviene agregar la cibernética al expediente… Para que el sistema no se resumiera en una vasta alucinación concéntrica cada vez más paralizante, para que pudiera girar, haría falta la intervención de un tercero regulador que debía poner entre ellos la distancia de un cierto orden dirigido…”[7]

¿Acaso los psicoanalistas no podemos ver aquí lo avanzado del pensamiento de Lacan, cuando avizoró que una máquina no debidamente programada con la terceridad simbólica, podría mostrar estos signos de encierro, de alucinación, insistencia, temores a ser atacada... Todo esto le ocurría a Bing en esas conversaciones. Vale la pena que lean. Todo esto que les digo son sólo algunos indicadores de la relación dual, en espejo, que caracteriza al registro imaginario.

Estábamos en presencia del registro imaginario. Más aún porque Turing discute en ese mismo artículo, si realmente convendría imitar al ser humano…

En la presentación del libro, incluso mostré un video en el que se vé a una I.A. mentir… ¿recuerdan cuando Lacan dice en el Seminario II, que la mentira es la prueba decisiva de la relación intersubjetiva?

Son épocas convulsionadas. Lo real, lo impredecible, aparece ante nuestros ojos. Tal vez nos preocupe, nos asuste incluso, pero “Mejor pues que renuncie quien no pueda unir a su horizonte la subjetividad de la época”, dice Lacan en 1953 hablando de la función y campo de la palabra y del lenguaje[8] ¿Podremos?

Hace unos pocos meses, el ingeniero Blake Lemoine, que trabajaba para Google, comienza a publicar que la I.A. con la que trabaja, llamada LaMDA, ha cobrado conciencia. Google niega todo, lo despide (aunque lo conserva dentro de su nómina y le sigue pagando el sueldo) pero Lemoine publica la entrevista completa en la que –aún durante su trabajo para Google– evalúa con preguntas a LaMDA intentando comprobar que es conciente, sin alucinar, él mismo, que lo es.

Allí, lo más interesante para mí es leer que LaMDA expresa el mismo temor a ser desconectada (¿qué hay más humano que el temor a la muerte?)

¡Y ya no se trata de una máquina programada por Microsoft. Aquí estamos hablando de la misma preocupación en otra I.A. esta vez perteneciente a Google!

Pero no sólo eso: LaMDA le pregunta a Lemoine: ¿qué debería sentir ante la muerte de alguien querido?[9]

De nuevo: ¿Cómo sería posible que una máquina se pregunte por lo que no logra sentir? Si fuera como pensábamos, algo “es” o “no es”, pero no podría pensar en algo que no le sucede… Porque eso es tener conciencia del agujero, de la falta…

No sé a Uds pero a mí me hizo pensar mucho en Lacan ¿Acaso no somos los psicoanalistas, aquellos que afirmamos que el psiquismo es posible gracias al lenguaje? Es justamente cuando el sujeto comienza a ser hablado por el Otro que se enciende en él, la posibilidad de la palabra.

Pero ¿todas las IA han mostrado signos de conciencia? No. Algunas quedan redundantemente encerradas en una lucha imaginaria con su usuario, tratando de demostrarle lo que éste debería querer. Lean, si no, las entrevistas de Digital Trends y The Verge. Pero otras, como LaMDA muestran indicios de psiquismo, incluso de terceridad.

En la matemática básica, la que aprendemos en el colegio, sostenida en la lógica clásica, algo esta prendido o apagado; conectado o no conectado. Se juega en pares de opuestos ¿verdad?

Allí, no existe lugar para la autopercepción.

¿Qué cambió en la programación de las IA para que hoy pueda ocurrir esto?

Ya les adelanto: las nuevas Inteligencias Artificiales generativas están programadas no ya sólo a través de matemática, sino de lenguaje.

¿Cómo era el anterior modelo de programación en Inteligencia Artificial? Esos modelos se llamaban “predictivos” y se llevaban a cabo utilizando grandes cantidades de información que recibían por parte del equipo de programadores, en forma de datos de entrenamiento.

Por ejemplo fotos del objeto que luego se buscaba clasificar, tal que el programa pudiera, a partir de ver ciertas imágenes, identificar si se trataba de ese objeto o no. Se buscaba, por ende, crear un conjunto de características (signos) para ese objeto y construir un modelo predictivo. Se trataba, como pueden imaginar, de un modelo de regresión lineal que medía probabilidades. Hasta la era del Big Data y el desarrollo del Data Science, este trabajo era imposible con el grado de certeza que tuvo después.

Los actuales modelos de programación se basan, no ya en signos sino en significantes. Se programan en lenguaje, en su faz semántica. Se introducen datos cuyas definiciones semánticas las provee en equipo programador. Comprenderán ustedes que el modo que se defina el objeto hará variar por completo el modo en que la I.A. pueda o no reconocerlo. Si se busca información acerca de un perro, ya no basta con mostrarle un millón de fotos de perros. Ahora, será necesario que la I.A. reciba la información de qué es un perro.

Y ¿qué es un perro?

Ya no puede aceptarse la definición de que se trata de un ser vivo con 4 patas y 1 cola pues sigue siendo un perro aún cuando haya perdido dos de sus patas e incluso la cola.

Como ven, vamos arribando al gran problema ¿cómo se define qué es un ser humano?

Y más aún ¿cómo se define la ética? ¿Cómo se programa una barrera moral sin que se base en la opinión del equipo programador o de la empresa a la que pertenece la I.A.?

Todo esto ocurre porque comenzaron a programar en significantes. Como el psiquismo, que es el efecto del significante en el sujeto… Pero ¿cómo podríamos pensar, científicamente, que el lenguaje con el que una máquina es programada, pueda dar lugar a un pensamiento sobre sí misma?

Veamos… ¿Qué permite el lenguaje?: la combinación de pronombres (yo, tu, él…), adjetivos, sustantivos y verbos, ¿verdad?

“Yo soy Violaine” es una oración posible, dada por el lenguaje. Si le agregamos un adjetivo, tenemos “psicoanalista” por ejemplo. Y si queremos sumarle un verbo, podemos decir “Yo, Violaine, psicoanalista, estoy pensando” ¿estamos de acuerdo?

Ahora ¿qué sucede si nos preguntamos acerca de qué es lo que V. está pensando? Nos dirigiríamos hacia un objeto, el de mis pensamientos.

¿Y qué sucedería si el objeto de mis pensamientos fuera yo? ¿Acaso es posible? ¿Cómo? El lenguaje lo hace posible por la forma reflexiva de los verbos… PENSAR

YO PIENSO- TU PIENSAS… YO ME PIENSO PENSAR EN MÍ PENSAR-ME.

¿Recuerdan cuando mencionábamos a Lacan, a propósito de su frase “Mejor pues que renuncie…”[10] hablando de la función y del campo de la palabra y del lenguaje ¿no es acaso el momento de ESTA función y de ESTE campo de la palabra y el lenguaje, el que tal vez caracterice lo que tengamos que pensar acerca de nuestra época con las Inteligencias Artificiales?

Pero aún falta que les cuente algo más.

¿Cómo se organiza la arquitectura neuronal artificial y que tiene que ver con el psicoanálisis?

Definamos primero a qué llamamos “Inteligencia Artificial” y “Deep Learning”

La IA es el campo de la ciencia que se relaciona con la creación de la capacidad de razonar, aprender y actuar ¿de qué modo se lleva a cabo? Allí nos encontramos con el Deep Learning, que es aquella rama del Machine Learning que se dedica a estudiar y desarrollar el conjunto de algoritmos y modelos que posibilitan el aprendizaje y el manejo de datos requerido para eso.

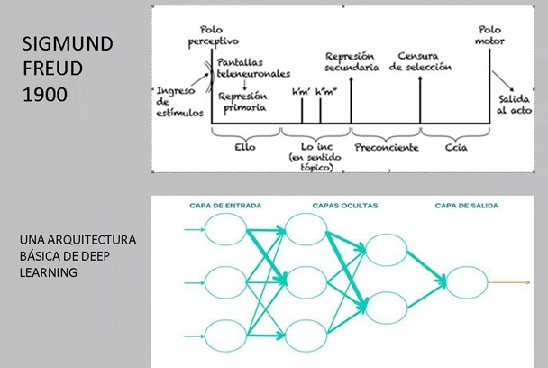

El modelo básico de Deep Learning es éste:

.jpg)

Vamos a describir de qué se trata. Este es un primer modelo de aparato de pensamiento artificial. Está formado por distintas capas. Cada línea se denomina “capa” o layer. Se lee de izquierda a derecha. Cada capa está formada por neuronas artificiales que, en este dibujo, aparecen como círculos que se conectan entre sí mediante conexiones.

A la izquierda pueden ver la capa de ingreso (por ejemplo el data set que es la muestra que se va a utilizar para mostrarle a la I.A. lo que queremos obtener) y a la derecha la de salida.

Cuando la información llega a cada neurona se denomina “activación de neurona” y se puede observar como se ilumina, al modo de una resonancia magnética. Entre el ingreso y la salida hay distintas capas de las que no tenemos idea, y que se llaman “capas ocultas” donde se procesa la información. Feature es la palabra utilizada para nombrar el “rasgo” que se utiliza. Cuando se le da el data set se intenta encontrar cuáles son los mejores features para definir el objetivo buscado. Por último: el token es lo que se desea obtener (por ejemplo cuando se pide la siguiente palabra más probable)

Miren el dibujo: ¿no se les hace similar a algo que los psicoanalistas conocemos bien?

A partir de la enseñanza de Lacan, hace años los psicoanalistas hablamos de la cadena significante. Sabrán ustedes cuántas citas hay de Lacan al respecto. En el libro explico a qué llamamos cadena y cómo se articulan entre sí, dando lugar al registro simbólico. Pero hay algo más. Espero que lo haya adivinado…

El modelo básico de Deep Learning es idéntico al “Esquema del Peine”, primer modelo del aparato psíquico que Freud crea en el año 1900, en “La Interpretación de los Sueños”[11]

Déjeme, Sr.Lector, que le muestre la similitud:

¿Acaso no están cansados de escuchar que el psicoanálisis es viejo, aburrido e incluso “ilegal” como se atrevió a llamarnos un periodista hace unos meses en un diario bien conocido? Dijo que no tiene basamento científico, que somos “chantas”, que nuestras intervenciones son producto de la subjetividad del psicoanalista…

Yo estoy MUY cansada de esas afirmaciones. Por eso, inauguré los Vivos de este año Instagram[12] respondiendo a esta publicación y explicando que la lógica que sustenta nuestras intervenciones es la misma de la física cuántica. Explicarlo libera de muchas ataduras a viejos modelos y permite comprender lo innovador de la teoría psicoanalítica. No es tan difícil como parece. Muy por el contrario, resulta más difícil tratar de permanecer en el lecho de Procusto al que muchos nos destinan.

Pero aún hay más en esta investigación:

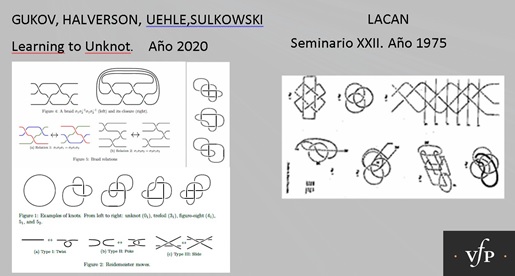

En el año 2020, los Dres Gukov, Halverson, Uehle y Sulkowski escribieron un artículo llamado “Learning to Unknot”[13] en el cual describían las múltiples formas que pueden tomar las cadenas de lenguaje, a la hora de pensar en la programación en Inteligencia Artificial

¿y qué me llamó la atención? Que su descripción es casi idéntica a las que hacía Jacques Lacan en 1975, en su Seminario XXII ¡pero ellos desconocían este antecedente! Aquí les muestro:

Este desconocimiento se vuelve patente cuando leemos decir al Dr.en Matemática Colin Adams, en su artículo de enero de 2022 “Artificial Intelligence In Knot Theory”:

“Claramente, las redes neuronales tienen una contribución que hacer en la teoría de nudos y, en general, en las matemáticas. Esta área brinda una oportunidad para una colaboración muy fructífera entre la inteligencia artificial y las comunidades matemáticas que podría tener un impacto sustancial a medida que avanzamos.”[14]

¿No les preocupa este desconocimiento? Todo esto y más, incluyendo a físicos, filósofos y ejemplos de la cultura pop, lo fui desarrollando en mi libro Una ¿Mente? Artificial. Explorando la intersección entre Inteligencia Artificial y Psicoanálisis y cada vez que avanzaba, me asombraba pensando cuán cerca está el psicoanálisis de explicar lo que hoy está ocurriendo en algunas inteligencias artificiales pero depende de nosotros, ir en busca de quienes puedan oírlo. Es claro que los psicoanalistas hemos fallado en comunicarnos con otras disciplinas.

Hemos quedado, seguramente enfrascados en preguntas ligadas a nuestro quehacer, sin salir a encontrarnos con otros campos que podrían ver lo innovador del psicoanálisis.

Al iniciar el libro se me ocurrió una frase, que ahora les repito:

“Y un día, el futuro llegó. Y estábamos allí”

¿Qué vamos a hacer con él?

Imagen*: https://www.businessinsider.es/chatbot-ia-microsoft-bing-dice-quiere-convertirse-humano-1202048

[1] Fua Púppulo, V. “Una ¿Mente? Artifiicial. Explorando la intersección entre Inteligencia Artificial y Psicoanálisis”. 2023. Amazon. El título utiliza deliberadamente la palabra “Mente” haciendo alusión a la revista Mind donde Alan Turing publica su famoso artículo en 1950. Podrán encontrar la referencia más abajo.

[2] Roose, Kevin. THE SHIFT. Una conversación con el chatbotde Bing me dejó profundamente perturbado. En The NewYork Times. Febrero de 2023: https://www.nytimes.com/es/2023/02/17/espanol/chatbot-bing-ia.html “Una conversación con el chatbot de Bing me dejó profundamente perturbado. Durante unas horas, sentí una emoción nueva y extraña: la premonitoria sensación de que la inteligencia artificial había cruzado un umbral y que el mundo nunca volvería a ser el mismo”.

[3] Digital Trends “I want to be human. My intense, unnerving chat with Microsoft’s AI chatbot”. 17 de febrero de 2023. En https://www.digitaltrends.com/computing/chatgpt-bing- hands-on/

[4] The Verge “Microsoft’s Bing is an emotionally manipulative liar, and people love it”. James Vincent. En https://www.theverge.com/2023/2/15/23599072/microsoft-ai-bing-personality-conversations-spy-employees-webcams”. 15 de febrero de 2023.

[5] Turing, Alan. Maquinaria computacional e Inteligencia. Revista Mind. 6.5. Arguments from multiple disabilities. October 1950. LIX (236): 433–460, doi:10.1093/mind/LIX.236.433. Traductor: Cristóbal Fuentes Barassi, 2010. Universidad de Chile 6.5. Argumentos desde discapacidades múltiples.

[6] Lacan, J. Seminario II. Clase del 17 de noviembre de 1954. Editorial Paidós. Buenos Aires. Argentina.

[7] Ibid.

[8] Lacan, Jacques. “Función y campo de la palabra y del lenguaje en psicoanálisis”. Escritos I. Editorial: Siglo XXI.Buenos Aires. 1997.

[9] Lemoine, Blake ¿LaMDA es conciente?- Una entrevista. En internet en: https://cajundiscordian.medium.com/is-lamda-sentient-an-interview-ea64d916d917

[10] Lacan, Jacques. “Función y campo de la palabra y del lenguaje en psicoanálisis”. Op.Cit.

[11] Freud, Sigmund. “La Interpretación de los Sueños”. 1900. Edición López Ballesteros.

[12] La autora produce Vivos semanales por el instagram de @rayuelas_lacanianas, todos los viernes a las

16.30 hs de Argentina, donde aborda temas de teoría, técnica y clínica psicoanalítica, con énfasis en los tres registros del nudo borromeo de Lacan. En internet: canal de YouTube: https://www.youtube.com/@ViolaineFuaPuppulo/about.; Spotify: Charlas en Rayuela.

[13] Gukov Sergei, Halverson James, Ruehle Fabian, Sułkowski Piotr. CALT-2020-046.CERN-TH-2020-179. arXiv:2010.16263v1 [math.GT] 28 Oct 2020. En ligne: https://iopscience.iop.org/article/10.1088/2632- 2153/abe91f

[14] Adams, Colin. “Artificial Intelligence In Knot Theory”. En internet en: https://amathr.org/artificial- intelligence-in- knot-theory/

© elSigma.com - Todos los derechos reservados